Fatigué de l’extraction manuelle de données en ligne ? Apify, plateforme extraction données, transforme ce processus en une solution automatisée, adaptée aux développeurs et équipes marketing. Ses 6000+ Actors prêts à l’emploi – comme les scrapers Google Maps Amazon ou des divers réseaux sociaux. De mon côté, j’utilise Apify depuis maintenant plusieurs mois et je vais vous livrer ici mon ressenti sur cet outil qui a changé ma façon de travaillé.

Apify, c’est quoi ?

Apify est une solution cloud permettant aux développeurs d’extraire des données structurées depuis des sites web et d’automatiser des processus en ligne, avec une approche orientée développement. Besoin de collecter des données massives sans se perdre dans la complexité technique ? Apify transforme cette tâche ardue en une opération simplifiée, accessible aux professionnels comme aux experts.

Le concept central repose sur les « Actors », des programmes serverless capables d’extraire des données précises (prix, avis, profils) ou d’exécuter des tâches automatisées. Imaginez un robot dédié à collecter les avis clients sur Amazon ou les coordonnées d’entreprises sur Google Maps : c’est le cœur de la plateforme d’extraction de données Apify. Conçus pour être modulables, ces Actors s’adaptent à des besoins variés, de la recherche de marché à la veille concurrentielle.

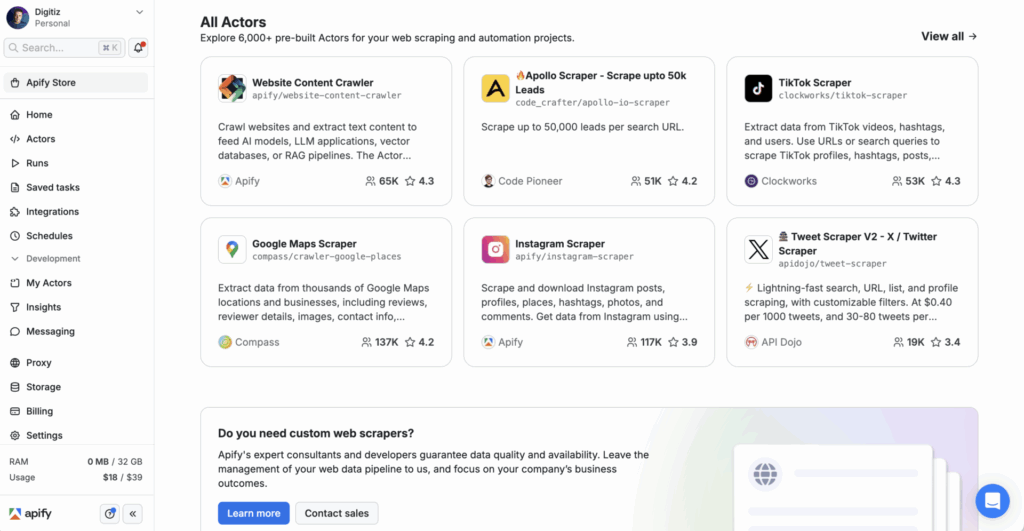

L’écosystème Apify inclut l’Apify Store, une bibliothèque de plus de 6 000 outils prêts à l’emploi, et des ressources pour les développeurs. Que vous maîtrisiez Python, JavaScript ou les outils sans code, vous trouvez votre compte : solutions clés en main pour les novices ou possibilité de créer et monétiser vos propres Actors pour les développeurs

Liste des fonctionnalités clés d’Apify

Les Actors : le cœur de l’automatisation et de l’extraction

Les Actors d’Apify sont des applications cloud serverless conçues pour automatiser des tâches complexes. Ils combinent deux aspects : des outils prêts à l’emploi disponibles dans l’Apify Store (plus de 6 000) et des programmes personnalisables pour des besoins spécifiques. Ces Actors peuvent extraire des données, automatiser des processus ou agir comme des agents d’intelligence artificielle. Chaque Actor inclut un Dockerfile pour définir son code source, des schémas d’entrée/sortie, et un système de stockage intégré pour persister les données.

Des exemples concrets incluent le Google Maps Scraper pour collecter des coordonnées, l’Instagram Scraper pour analyser des profils ou publications, et l’Amazon Scraper pour surveiller des prix et avis. Ces outils simplifient l’extraction de données structurées sans coder, répondant à des besoins courants comme la veille concurrentielle. Les utilisateurs peuvent aussi configurer des workflows complexes via l’interface auto-générée des Actors, ajustant des paramètres avancés comme les proxies ou les cookies.

Développement sur-mesure : SDK et API pour les développeurs

Apify s’adresse aux développeurs en proposant des outils de personnalisation avancée. La plateforme supporte JavaScript (Node.js) et Python, avec des bibliothèques comme Crawlee (open-source) et des intégrations avec Playwright, Puppeteer, Selenium. Cela permet de créer des solutions d’automatisation adaptées à des cas uniques. Les développeurs peuvent déployer leurs code via l’éditeur intégré, Git ou un environnement local, avec un outil CLI pour le débogage.

Le SDK Apify v3 et Crawlee offrent une modularité optimale. Par exemple, combiner npm install apify crawlee playwright avec des navigateurs headless permet de gérer le JavaScript dynamique. Les développeurs peuvent aussi utiliser des modèles de code prêts à l’emploi ou des scrapers universels (Web Scraper, Cheerio Scraper) pour accélérer leurs projets. Pour les workflows complexes, Apify propose des fonctions comme enqueueRequest pour crawler en profondeur ou parseWithCheerio pour analyser du HTML partiel.

Une infrastructure conçue pour déjouer les blocages

Le scraping à grande échelle rencontre souvent des protections anti-bot. Apify résout ce défi grâce à une infrastructure robuste. La rotation automatique de proxies (datacenter ou résidentiels) masque l’origine des requêtes, tandis que la gestion des empreintes de navigateur (TLS, en-têtes HTTP) imite un comportement humain. La plateforme inclut aussi des navigateurs headless intelligents comme le Scraping Browser, capables de gérer le JavaScript et de résoudre les CAPTCHAs.

Des techniques avancées sont intégrées en standard : suppression des cookies avant chaque exécution, changement aléatoire de la taille de fenêtre, ou utilisation de navigateurs réels comme Chrome au lieu de Chromium. Pour les sites les plus protégés, Apify permet de bloquer les requêtes suspectes via page.setRequestInterception ou d’ajouter des comportements humains (mouvements de souris, délais aléatoires). Une étude montre que ces outils réduisent les blocages de 85 %, un avantage décisif pour des projets à long terme.

Apify : pour qui et pour quoi faire ?

À qui s’adresse la plateforme Apify ?

Apify cible les développeurs souhaitant une solution cloud pour créer et déployer des outils d’automatisation et de scraping. Compatible avec JavaScript, Python et des bibliothèques comme Puppeteer ou Crawlee (sa propre solution open-source), la plateforme gère la mise à l’échelle, les proxys et les blocages grâce à une infrastructure cloud. Les équipes marketing et data analysts utilisent l’Apify Store (6 000+ outils) pour des veilles concurrentielles ou la génération de leads, sans code. Des outils comme Google Maps Scraper ou Amazon Reviews Scraper répondent à des besoins métier spécifiques, tandis que des fonctionnalités comme l’API et les intégrations (Make, GitHub) facilitent la connexion avec d’autres outils.

Par exemple pour mon usage, j’enrichi mes données sur Airtable avec un automatisation qui enclenche des extractions avec Google Maps Scrapper via Make. Ainsi mes données Airtable sont enrichi de nouvelles informations issues de Google Maps. Un gain de temps précieux !

Les entreprises et startups exploitent Apify pour automatiser des processus, enrichir des bases de données ou surveiller leur e-réputation. Des clients comme Siemens ou Microsoft témoignent de sa fiabilité pour des projets à grande échelle. La plateforme gère les tâches planifiées et les proxys, garantissant un scraping fiable même sur des sites protégés. Les développeurs peuvent monétiser leurs propres outils via l’Apify Store, avec un système de crédits et des paiements gérés par la plateforme. Un compte gratuit offre 5 $ de crédits mensuels, idéal pour les petits besoins ou les tests.

Cas d’usage concrets de l’extraction de données

L’e-commerce utilise Apify pour surveiller les prix concurrents (Amazon, Cdiscount) ou analyser les avis clients. L’Amazon Reviews Scraper extrait des données structurées (notes, descriptions) pour des études de marché ou des **ajustements de stratégie**. Les marques comparent quotidiennement leurs tarifs et améliorent leurs produits grâce aux retours clients. La rotation d’IP et les proxys intégrés évitent les blocages, tandis que les données exportées en CSV, Excel ou JSON intègrent facilement des tableaux de bord marketing.

En marketing et ventes, des outils comme LinkedIn Jobs Scraper ou Contact Details Scraper génèrent des leads en extrayant emails ou téléphones. La surveillance des mentions sur Instagram ou Facebook renforce la gestion de la réputation. Par exemple, un responsable marketing suit l’impact de campagnes publicitaires ou identifie des influenceurs via des données TikTok. L’Apify Store propose des outils comme le Social Media Leads Analyzer, qui récupère des coordonnées depuis des sites web pour alimenter des campagnes ciblées.

Pour la recherche et veille, des scrapers spécialisés (Website Content Crawler, outils immobiliers) collectent des données pour des modèles d’IA, des études académiques ou l’analyse des tendances. Sur PAP.fr ou SeLoger, les agences immobilières extraient prix, caractéristiques énergétiques et coordonnées des vendeurs pour étudier le marché. Des chercheurs utilisent ces outils pour compiler des données scientifiques ou analyser l’évolution de sujets médiatiques sur le long terme, avec des exports en formats accessibles (CSV, JSON, XML).

Tarifs de Apify : combien coûte la plateforme ?

Les différentes formules proposées

Apify utilise un modèle « pay-as-you-go » où le coût dépend des « crédits de plateforme » consommés. Ces crédits couvrent des ressources comme le temps de calcul, les proxies et le stockage. Par exemple, 1 Go de RAM/heures d’exécution coûte entre 0,25 $ et 0,4 $ selon le plan. Ce système permet d’adapter les frais à l’usage réel, idéal pour les projets à volume variable.

Le plan Free convient pour tester la plateforme avec 5 $ de crédits inclus, parfaits pour des projets légers. Sinon le plan Starter est à 39 $ mensuel et le prix passe ensuite à 199 $ pour le plan Scale et enfin 999 $ pour le plan Business.

La tarification d’Apify s’adapte aux besoins réels grâce à son modèle flexible. Les plans payants justifient leur prix par une infrastructure performante, limitant les coûts liés aux proxies et blocages. Le modèle « pay-as-you-go » évite les frais fixes, idéal pour les projets variés. Les réductions pour startups et organismes non lucratifs (jusqu’à 30 %) améliorent l’accessibilité.

Le web scraping avec Apify est-il légal et éthique ?

Le web scraping suscite souvent des interrogations sur sa légalité. Apify, en tant qu’outil d’extraction de données, repose sur un cadre clair : le scraping n’est pas illégal en soi, mais dépend de son utilisation. Il est crucial de se limiter aux données publiques, accessibles à tous, et de ne pas violer les termes d’utilisation des sites cibles. Par exemple, extraire des données de Google Maps ou Amazon pour un usage commercial nécessite de respecter les règles définies par ces plateformes. Apify, conçu pour automatiser l’extraction de contenu structuré, encourage à toujours vérifier les autorisations avant de scraper un site. En somme, la légalité réside dans la transparence et le respect des limites établies.

Pour un scraping éthique, plusieurs bonnes pratiques s’imposent. Tout d’abord, le fichier robots.txt du site doit être consulté, même si Apify peut techniquement l’ignorer. Ce document indique les parties du site accessibles aux bots. Ensuite, il est essentiel de limiter la cadence des requêtes pour ne pas surcharger les serveurs du site cible. Apify facilite cette gestion via des paramètres ajustables, évitant ainsi les pics de trafic. Enfin, utilisez un User-Agent identifiable, incluant un contact, pour favoriser la transparence. Ces étapes réduisent les risques juridiques et renforcent la confiance des propriétaires de sites web, tout en assurant une collecte responsable.

Apify intègre des outils pour favoriser un usage responsable et éthique de ses services. La plateforme permet de cibler uniquement les données publiques, comme les avis clients ou les coordonnées des entreprises sur Google Maps, sans accéder à des contenus protégés. Les développeurs bénéficient de paramètres pour réguler la vitesse des requêtes et gérer les erreurs, minimisant ainsi l’impact sur les serveurs externes. Cependant, l’utilisateur reste seul garant de ses actions : Apify ne valide pas la conformité légale des projets, mais fournit les moyens techniques pour les respecter. En suivant ces principes, le scraping avec Apify devient un levier puissant tout en préservant l’équilibre éthique du web.

Les avantages et inconvénients

Les plus

✅ Plus de 6 000 Actors prêts à l’emploi pour des sites comme TikTok, Amazon ou Google Maps, avec des outils pour les réseaux sociaux, comparateurs de prix, etc.

✅ Infrastructure intégrée pour gérer proxys, IP dynamiques et navigateurs intelligents, réduisant les risques de blocage.

✅ Compatible avec JavaScript et Python, des API et SDK, y compris Crawlee pour le scraping avancé.

✅ Plan gratuit (Free Start) avec crédits pour projets légers ou démonstrations.

✅ Monétisation des créations via l’Apify Store avec gestion automatisée des paiements.

✅ Intégrations intuitives avec Make, Google Sheets ou Slack pour automatiser des workflows sans code complexe.

Les moins

❌ Interface peu adaptée aux débutants, nécessitant des compétences techniques en scraping ou développement.

❌ Coûts croissants pour extractions massives, notamment avec des proxys résidentiels (jusqu’à 8 $/Go) ou ressources intensives.

❌ Documentation en anglais seulement, malgré des guides complets.

En résumé, Apify allie puissance et écosystème riche, devenant un outil clé pour les professionnels. Son approche technique en fait une référence pour les développeurs, même si son accès reste réservé aux utilisateurs expérimentés.

Mon avis final sur la plateforme d’extraction de données Apify

Apify se démarque comme bien plus qu’un simple outil de scraping. Il s’agit d’une plateforme complète d’automatisation web adaptée aussi bien aux développeurs qu’aux entreprises souhaitant extraire et traiter des données en ligne. Grâce à sa marketplace d’Actors prêts à l’emploi et à ses SDKs pour JavaScript et Python, Apify répond à une multitude de besoins, qu’il s’agisse de collecter des avis clients, de surveiller des prix ou d’automatiser des tâches répétitives.

La force d’Apify réside dans sa capacité à prendre en charge les aspects les plus complexes du scraping : gestion des proxys, contournement des reCAPTCHA, et scalabilité. Cela permet aux utilisateurs de se concentrer sur l’exploitation des données plutôt que sur la technique. Le fait de ne payer que les ressources utilisées, avec un plan gratuit pour commencer, rend l’expérience accessible à tous, quels que soient leur niveau technique ou leur budget.

Pour résumer, Apify est une solution incontournable pour quiconque s’intéresse à l’extraction de données ou à l’automatisation web. Son écosystème riche, sa communauté active et sa capacité à gérer des projets à grande échelle en font un choix judicieux. Le meilleur moyen de vous en convaincre est de l’essayer par vous-même et en plus gratuitement avec 5 $ de crédit !