Dernière modification le 3 novembre 2023

Si vous cherchez à augmenter la visibilité de votre site sur les moteurs de recherche, l’audit SEO est la première chose à faire pour atteindre vos objectifs. Pour vous aider à effectuer une analyse complète de votre site, je vous ai détaillé ici toutes les étapes indispensables pour votre audit SEO.

Sommaire

Pourquoi faire un audit SEO ?

Un audit SEO est une analyse complète de chacun des facteurs du référencement naturel qui permettent d’améliorer la visibilité de votre site web dans les moteurs de recherche.

On retrouve parfois des services qui vous proposent souvent de réaliser un audit gratuitement. Le problème est que ces solutions en ligne ne vont vous faire que des analyses limitées à quelques problèmes basiques de votre site. La meilleure approche pour analyser en profondeur votre site est d’effectuer l’audit manuellement en suivant une méthodologie précise (comme celle que je vais vous présenter) ou bien de demander l’aide d’un consultant SEO pour vous faire gagner du temps.

En d’autres termes, l’objectif de l’audit SEO est de mieux comprendre pourquoi votre site n’attire pas davantage de visiteurs comme il le devrait. La finalité de cet audit sera de vous fournir toutes les recommandations afin d’améliorer la performance du site Web dans les moteurs de recherche.

Quels outils pour analyser son site ?

Maintenant que vous êtes prêt à effectuer un audit SEO de site, je vous recommande d’utiliser quelques outils pour mieux comprendre le fonctionnement de votre site, d’identifier les erreurs et les points d’amélioration :

Bien sûr, il existe d’autres alternatives selon vos besoins. Je vous invite à voir mon article à sujet où je sélectionne les meilleurs outils SEO. Dans tous les cas, il faut garder en tête que la majorité est payante et que la qualité à un prix !

Étape 1 : Vérifier le trafic et le positionnement des pages

Cette première étape est indispensable puisqu’elle permet de faire un état des lieux de la performance des pages de votre site ce qui servira ensuite à faire l’audit des contenus.

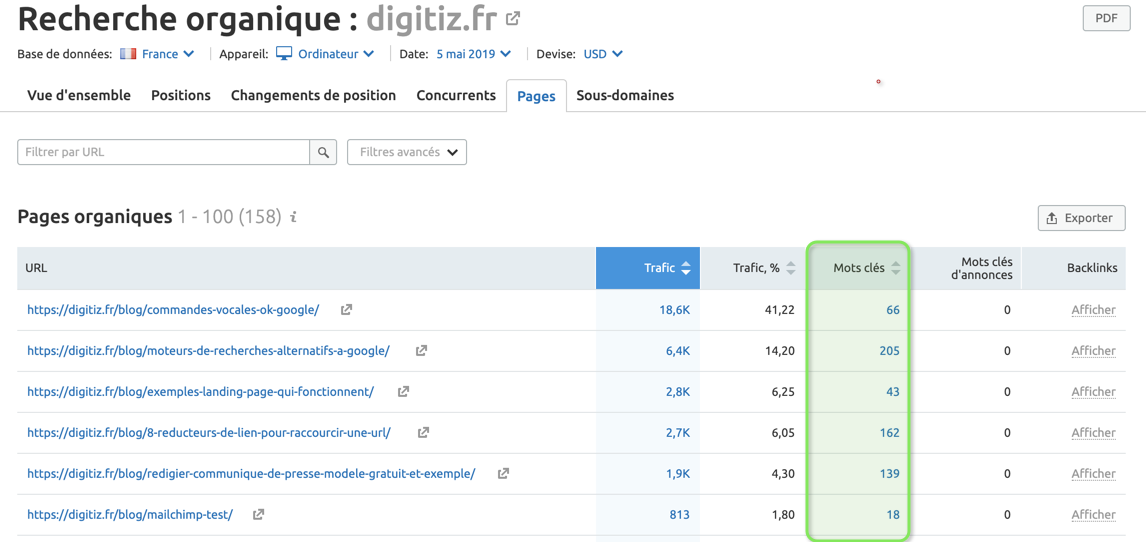

Etat des lieux du positionnement des pages avec SEMrush

Pour commencer, regardons d’abord quelles sont les pages qui génèrent le plus de trafic naturel sur notre site et quelles sont celles qui n’arrivent pas à se positionner sur des mots-clés. Pour cela, SEMrush (voir mon test) est très pratique parce non seulement il trouve automatiquement tous les mots-clés sur lesquels vous êtes classé mais il les regroupe aussi par page.

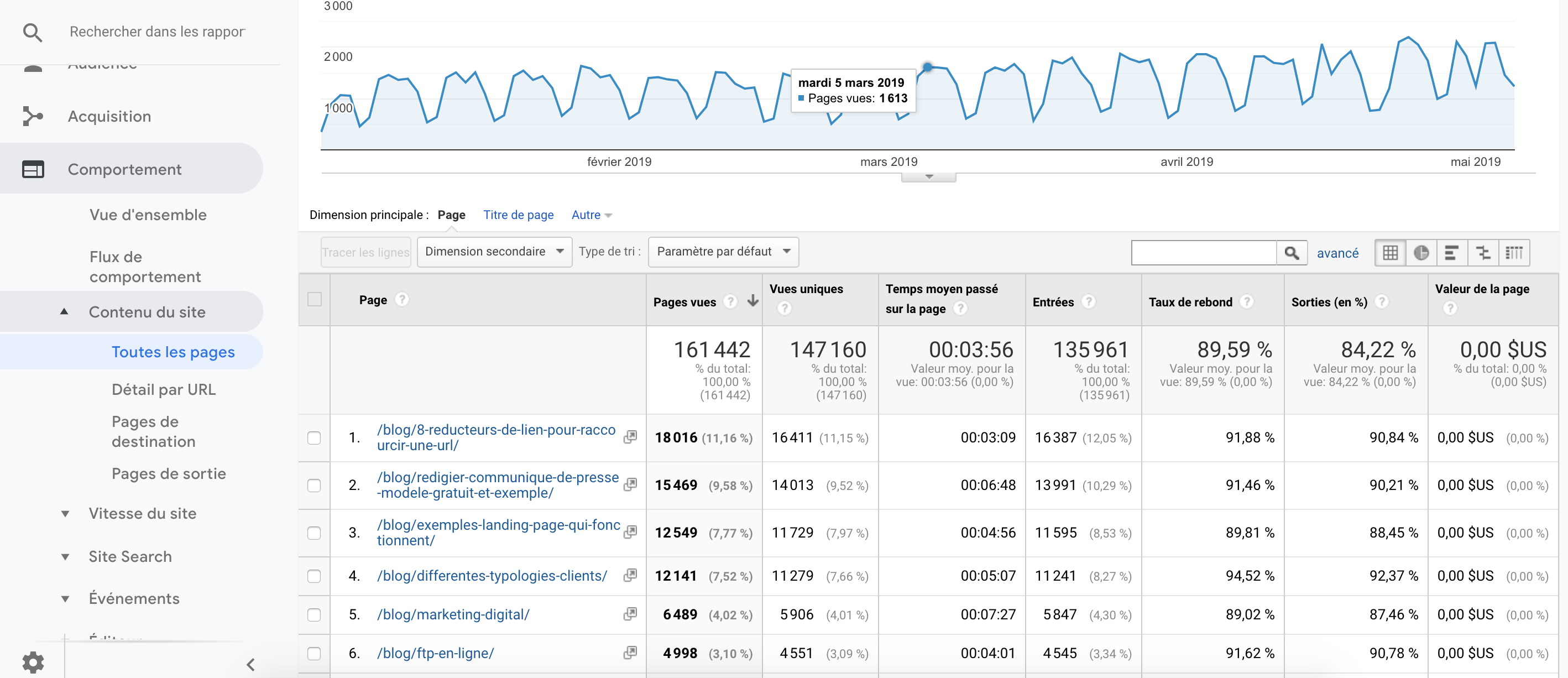

Vérification du trafic généré avec Google Analytics et Search Console

Le comportement des utilisateurs révèle parfois des erreurs et des problèmes d’ergonomie sur votre site. Pour savoir comment les visiteurs le parcourent, vous pouvez analyser les URL de manière individuelle à l’aide de Google Analytics. L’outil vous fournit des statistiques liées aux interactions clés telles que les taux de rebond, le temps moyen passé sur le site et bien sûr le trafic généré. Le rapport est disponible dans la l’onglet Comportement > Contenu du site > Toutes pages.

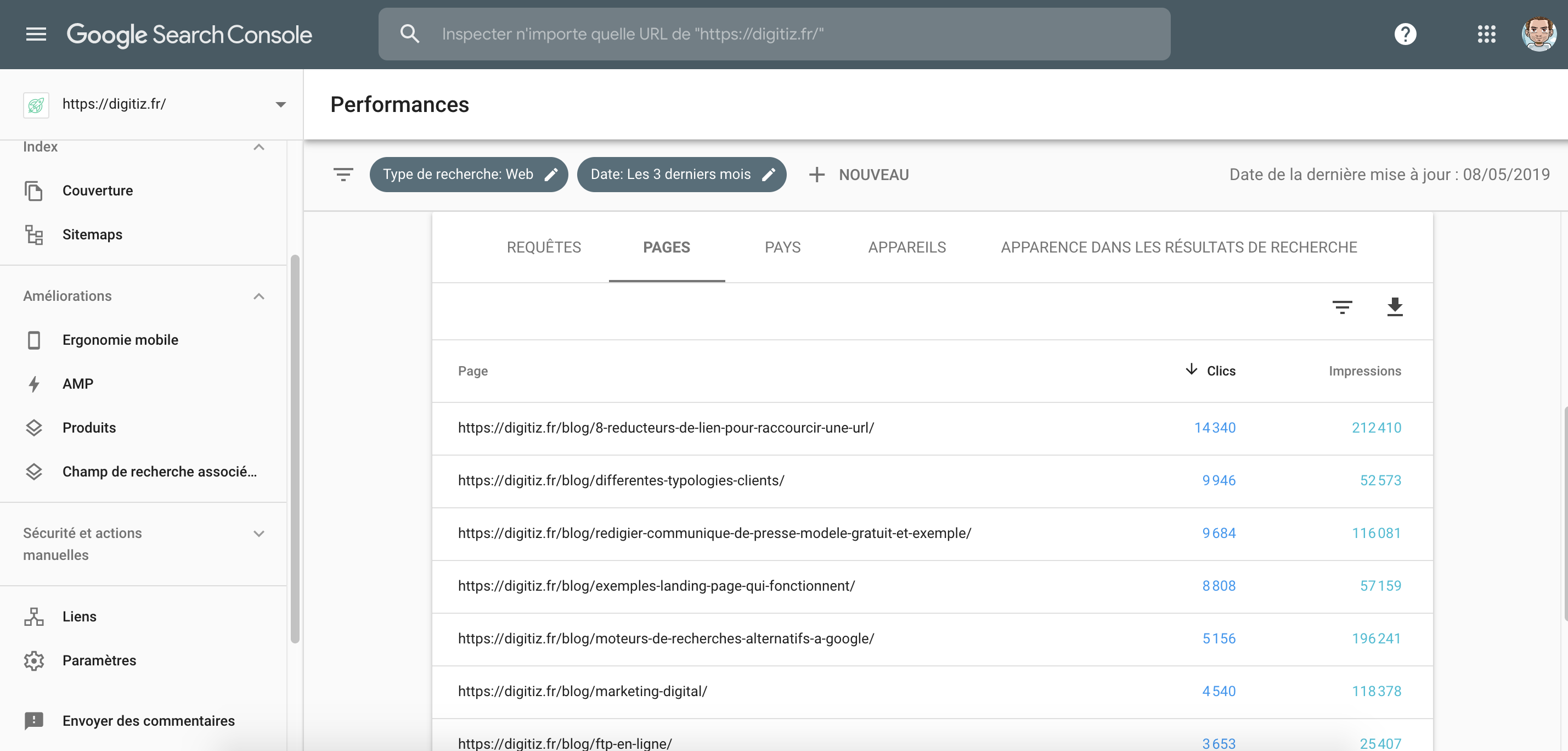

Avec Google Search Console, vous pouvez directement voir les requêtes que tapent les internautes pour visiter votre site. En allant dans l’onglet « pages » vous retrouverez les pages les plus performantes de votre site avec le nombre de clics et d’impressions dans les résultats de Google.

Étape 2 : Analyser les contenus

Le contenu est la première matière de vos pages pour qu’elles puissent se positionner correctement dans les moteurs de recherche. Nous allons voir comment bien les analyser afin de les optimiser ensuite.

Distinguer les pages performantes et non-performantes

Suite à l’état des lieux du positionnement et du trafic, on peut distinguer d’un côté les pages performantes et les pages non-performantes.

Vous allez me demander qu’est ce qu’une page performante ? Et bien il s’agit tout simplement d’une page qui arrive à se positionner en 1ère page de Google (position 1 à 10) et qui génère du trafic. Pour l’instant nous n’allons pas toucher à ces pages car elles fonctionnent plutôt bien et nous allons nous concentrer sur les pages non-performantes.

Une page non-performante peut l’être pour plusieurs raisons :

- Elle est de mauvaise qualité : La page peut manquer de contenu mais elle peut aussi être mal rédigée ou encore mal structurée au niveau des balises. Dans ce cas, il faudra identifier les problèmes pour l’optimiser.

- Elle fait doublon avec une autre page : S’il existe une autre page qui traite du même sujet, Google n’en mettra qu’une seule en avant. La page la moins performante qui fait doublon doit être redirigée en 301 vers la page qui a le plus de potentiel.

- Elle est non pertinente : Il se peut enfin que la page ne vise pas de mots-clés particulièrement recherchés. La page peut toutefois servir à un autre objectif que le SEO (page d’aide, contenu viral, page de vente, etc…). Si ce n’est pas le cas, il peut parfois être judicieux de réorienter la page vers un autre mot-clé plus recherché.

Les critères à analyser au niveau du contenu

La qualité et la longueur des contenus

Vos pages auront peu de chances de remonter dans les résultats de recherche si le contenu est peu étoffé et ne répond pas aux besoins des utilisateurs. Un article de blog de 300 mots expliquant un concept complexe serait considéré comme peu qualitatif. Cela dit, il n’est pas forcément réaliste de mettre 1000-2000 mots sur certaines pages de votre site (comme la page d’accueil ou les pages produits).

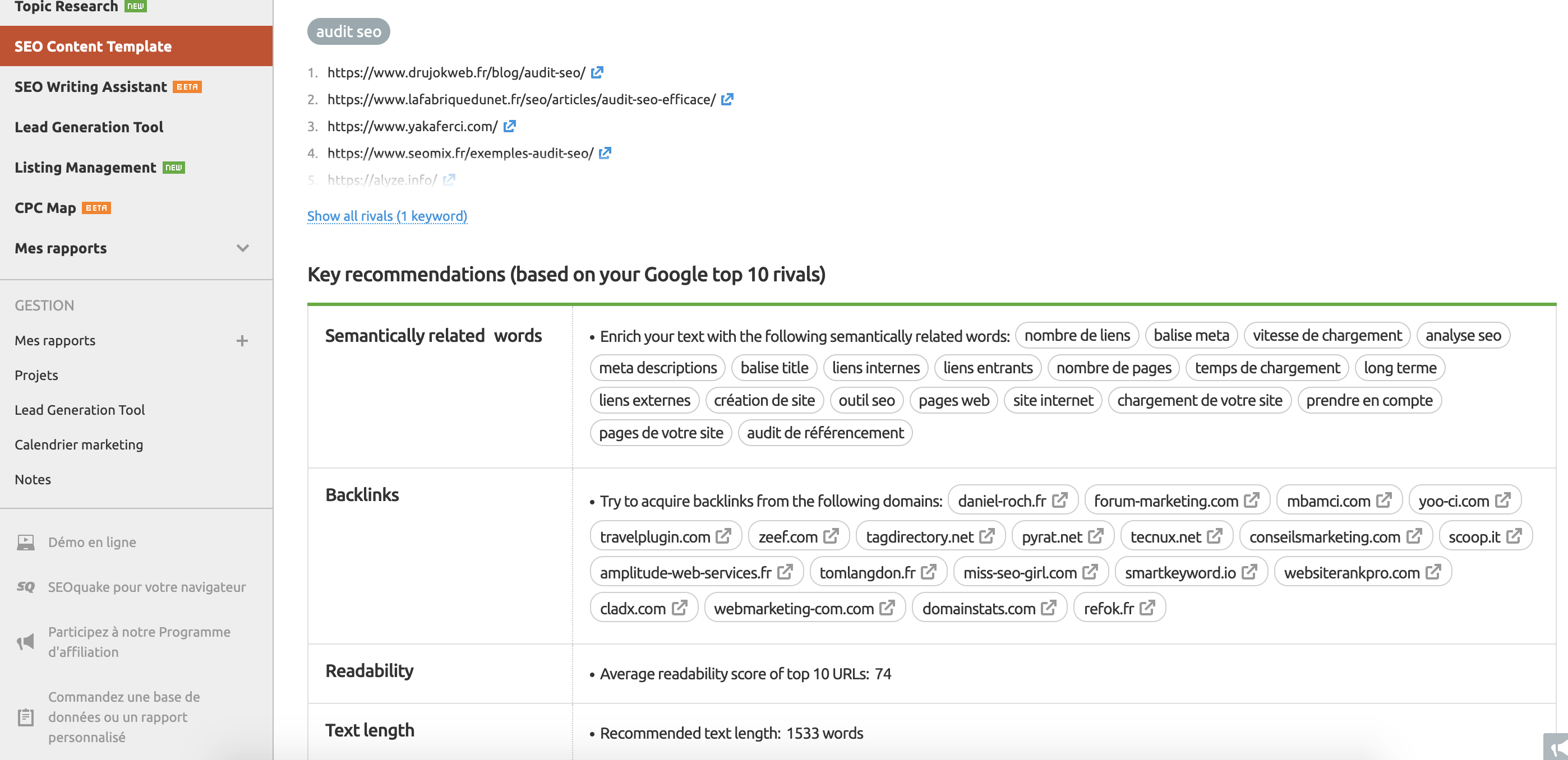

Vous devez parcourir chaque page individuellement et faire des recommandations au niveau du texte et des différents éléments qui l’entoure. Vous pouvez vous aider de la fonctionnalité SEM Content Template de SEMrush. Par rapport à votre requête initiale, celui-ci va analyser les premiers résultats de Google et vous donner différentes indications en ce qui concerne des expressions à intégrer ou le nombre de mots minimum.

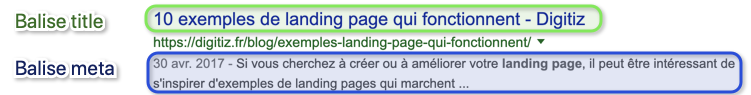

Les balises titles et meta descriptions

Pour rappel, la balise title aide Google à comprendre le contenu de la page qu’il parcourt et est un facteur des plus importants dont Google tient compte pour déterminer son classement. Ensuite, la balise meta description est quant à elle moins importante car elle peut être générée automatiquement par Google. Elle permet d’accrocher l’utilisation de Google pour donner envie de cliquer sur votre résultat plutôt que celui d’à côté.

Avec la fonctionnalité Site Audit de SEMrush, vous pouvez facilement identifier les balises manquantes ou en double dans vos différentes pages.

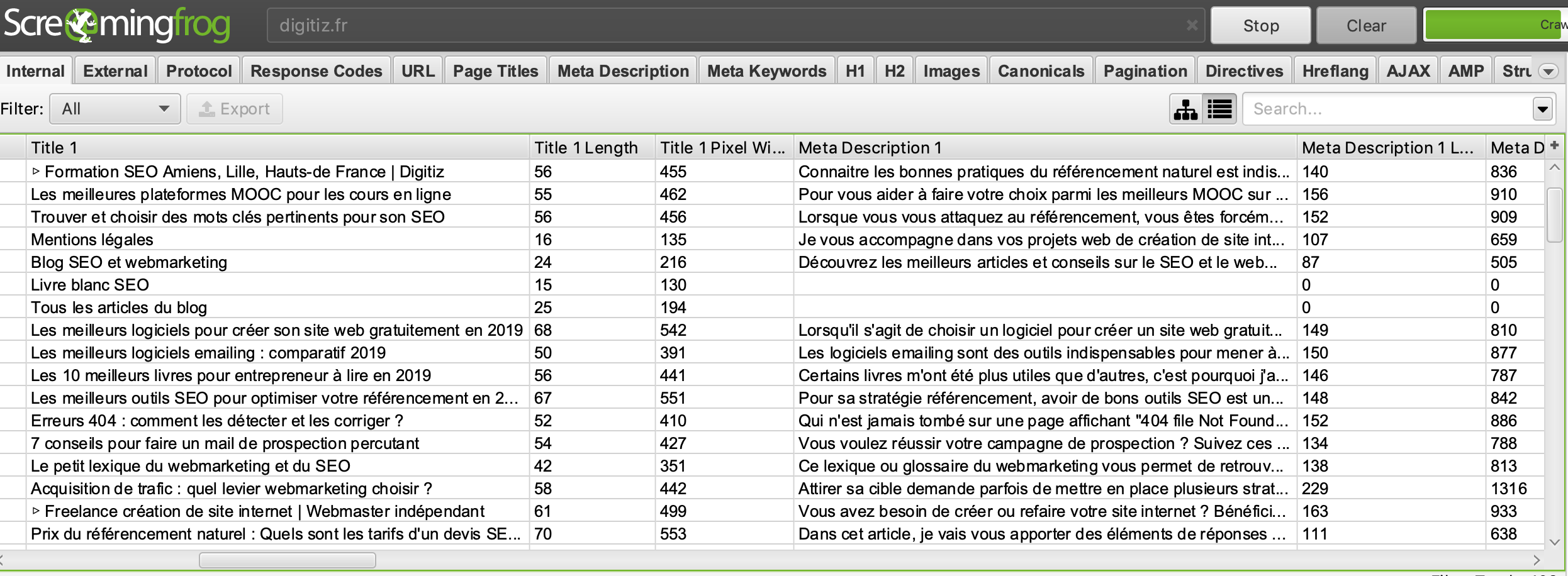

Si vous voulez voir rapidement l’ensemble de vos balises, je vous conseille de faire un crawl avec Screaming Frog.

Réécrivez vos balises titles et meta description en restant cohérent par rapport à votre stratégie de mots-clés et en vous assurant de les optimiser correctement par rapport aux standards de Google.

Les balises Hn et structuration du contenu

Tout texte doit être correctement formaté en utilisant H1 pour le titre principal, H2 pour les titres des paragraphes et éventuellement H3 pour les sous-parties. Vous devez inclure votre mot-clé principal et ses variantes dans votre H1 et dans quelques H2 en veillant à rester naturel. Le gras et italique peuvent être utilisés pour des phrases importantes. Toutefois, il est complètement inutile et contre-productif de répéter plusieurs fois votre même mot-clé en le mettant en gras plusieurs fois dans le corps du texte.

Pour rendre votre texte plus lisible, n’hésitez pas à faire des listes numérotées ou à puces. Les images doivent également être optimisées avec la balise alt et ne pas être trop lourdes afin de minimiser le temps de chargement.

Duplication interne et externe

Il peut arriver que du contenu soit dupliqué à l’intérieur de votre site ou même qu’une de vos pages ait un contenu similaire avec une page d’un site externe.

Dans le cas de la duplication interne, vous pouvez utiliser les redirections 301 à l’aide du fichier .htaccess pour rediriger les internautes et les robots d’exploration. Il y a des cas légitimes où plusieurs URLS peuvent avoir le même contenu. Dans ce cas précis, il est possible d’indiquer à Google quelle URL lui semble être la référence par rapport aux autres grâce à la balise canonical.

Pour ce qui concerne la duplication externe si vous avez été plagié, vous pouvez d’abord contacter le plagiaire pour lui demander d’enlever les contenus copiés. Vous pouvez également avertir l’hébergeur du caractère illicite du site plagiaire en engageant sa responsabilité. Signalez le vol du contenu à Google depuis ce formulaire. En dernier recours, vous pouvez procéder à un constat d’huissier et porter plainte.

Étape 3 : Améliorer la structure du site

Votre structure de site est une autre partie critique du référencement. Il s’agit tout simplement de la façon dont les pages de votre site Web sont organisées.

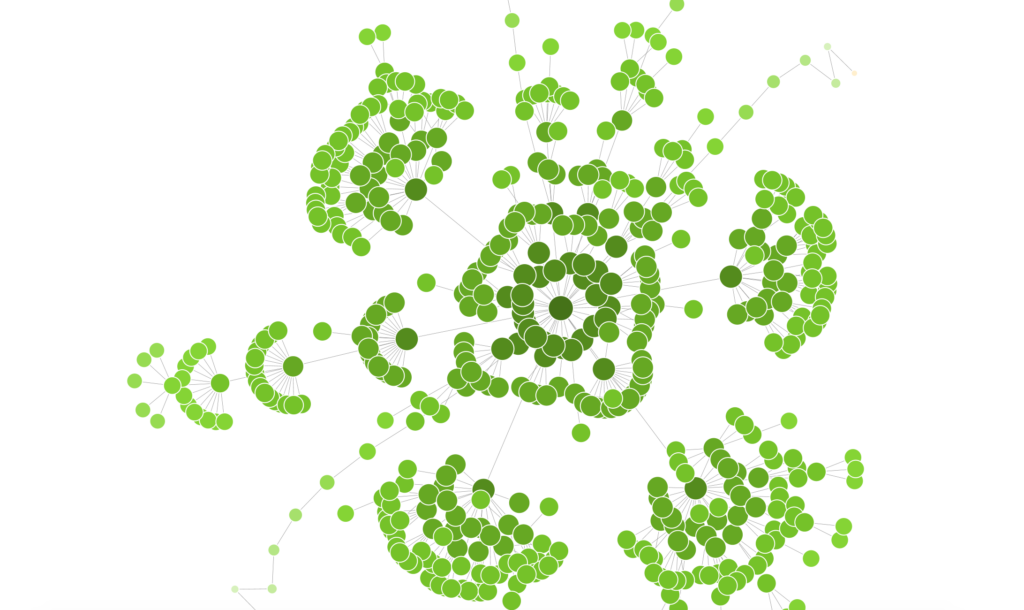

Comprendre l’architecture du site

L’architecture de vos pages web et les liens internes facilitent la navigation et équilibrent la distribution de l’autorité transmise par d’autres pages à votre site.

Pour avoir un aperçu de l’architecture de votre site, Screaming Frog permet de schématiser un diagramme une fois le crawl du site réalisé.

Il existe différentes écoles de pensée à ce sujet. Certains référencement vont dire qu’avoir une architecture plate est meilleure pour accéder à toutes les pages avec moins de 2 clics. D’autres (dont je fais partie) pensent qu’une architecture en silo est meilleure pour améliorer la compréhension de Google.

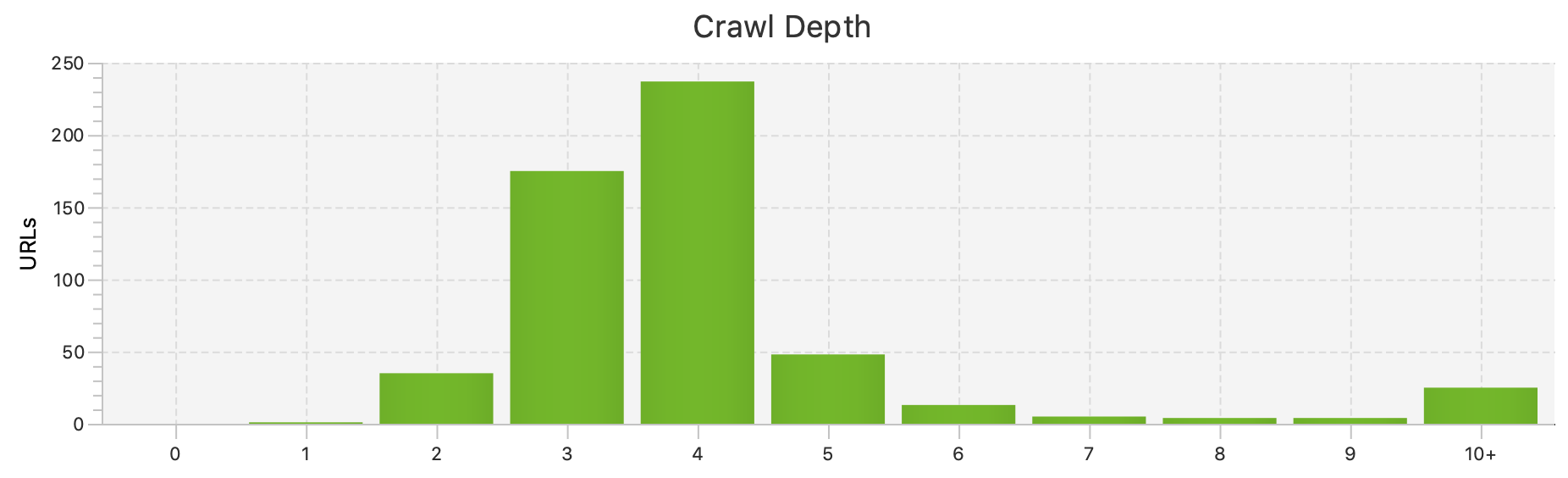

Repérer les pages profondes et orphelines

Lorsque vous inspectez la structure de votre site, il est important de vérifier le niveau de profondeur de chacune de vos pages. Avoir des pages à un niveau supérieur à 6 ou 7 peut commencer à poser des problèmes.

Screaming Frog permet d’analyser la profondeur de vos pages en un coup d’œil.

Vous pouvez ainsi identifier les pages qui sont trop profondes pour les utilisateurs et les moteurs de recherche. À partir de là, c’est à vous de choisir où vous aller replacer ces pages dans la structure de votre site.

Il peut également y avoir des pages orphelines n’étant pas liées au reste du site par des liens internes. Les robots d’exploration ne peuvent alors pas accéder à ces URL pour les crawler. Ce problème se produit généralement après une refonte de l’architecture d’un site au cours de laquelle les liens ou les menus de navigation ont été modifiés. Ces pages peuvent alors être encore indexées par Google mais perdent de leur puissance n’étant plus liées à d’autres pages.

L’état du maillage interne

Le maillage interne est utile à la fois pour les moteurs de recherche et les utilisateurs. Assurez-vous que vous avez bien lié vos pages connexes entre elles en vérifiant plusieurs éléments :

- Utiliser les bons ancres de lien avec un profil varié.

- Lier en priorité les pages que vous souhaitez pousser sur Google.

- Inclure entre 2 et 10 liens internes par page.

Faites attention aux pages orphelines. Il s’agit de pages avec peu de liens pointant vers elle voire aucun. Elles sont donc pratiquement invisibles aux yeux de Google puisque les robots ne peuvent pas y accéder.

Étape 4 : Identifier les problèmes techniques

Avec les outils que vous avez à disposition, il est possible de détecter de nombreuses erreurs techniques sur le site que vous analysez. Voici les principales à regarder :

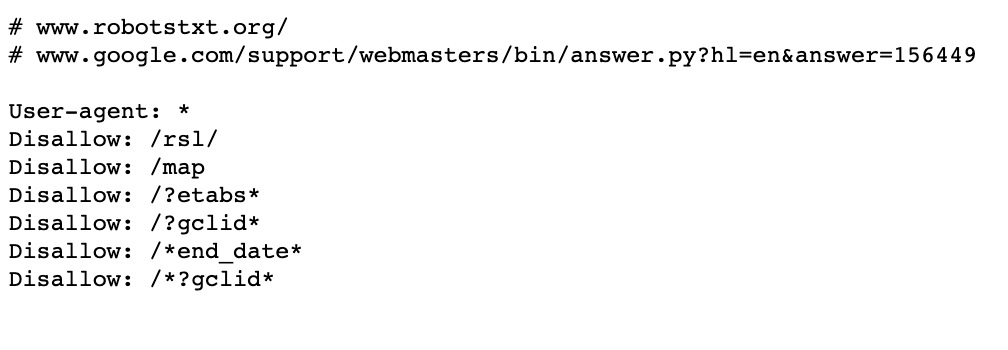

Vérifier le fichier robots.txt

Robots.txt est un petit fichier texte que parcours les robots des différents moteurs de recherche afin d’explorer votre site web. Il contient de nombreuses instructions à l’attention des robots, permettant ainsi de contrôler directement les opérations d’exploration et d’exclure certaines pages si besoin. En effet, Google a des ressources finies et limitées et il a tout le web à crawler. Il alloue donc un temps limité à crawler chaque site que l’on appelle le budget de crawl.

Si vous souhaitez vérifier votre fichier robots.txt, vous pouvez le trouver à la racine de votre domaine www.exemplededomaine.com/robots.txt. S’il ne s’y trouve pas il faudra alors en créer un.

Vous pouvez optimiser le budget de crawl en bloquant des pages non nécessaires au référencement :

- Les pages ?etabs

- Les pages ?gclid

- Les pages liées à la recherche search

HTTPS

Avoir un site Web sécurisé est l’une des priorités de Google et c’est pourquoi ils ont d’ailleurs officiellement confirmé que le HTTPS pour être l’un des facteurs de classement.

Le protocole HTTPS signifie que votre connexion est sécurisée par un certificat SSL qui crypte le lien entre le serveur et le navigateur. Cela permet une navigation sécurisée et des paiements protégés. Voici les étapes pour activer le HTTPS

- Obtenir un certificat de sécurité SSL

- Faire des redirections des pages et ressources HTTP vers les nouvelles URLs en HTTPS

- Mettre à jour Google Search Console

Réparer les liens cassés

Les liens cassés sur votre site sont préjudiciables pour votre référencement naturel mais aussi pour votre expérience utilisateur. À noter que les liens cassés peuvent concerner aussi bien les liens internes qu’externes. Dans les deux cas, ils affectent votre référencement en diluant votre Page Rank.

Vous pouvez vous rendre dans votre Google Search Console et chercher manuellement les liens brisés dans le rapport de couverture. Vous pouvez également utiliser un outil (gratuit) comme Broken Link Checker pour inspecter les liens sur votre site Web.

Les codes de réponses

Des codes de réponses corrects et des redirections qui fonctionnent contribuent à une meilleure expérience utilisateur. Lorsqu’un internaute envoie une requête à un serveur, ce dernier doit en théorie répondre par le code de statut « 200 OK ». Si une page n’est plus disponible, une erreur de type « 4xx » s’affiche. Les codes « 5xx » sont quant à eux des erreurs liées à votre serveur.

Afin d’identifier ces erreurs, vous pouvez également utiliser Screaming Frog ou bien Google Search Console. Pour les pages qui renvoient des erreurs 404, utilisez les redirections 301 vers les bonnes pages afin de les corriger correctement.

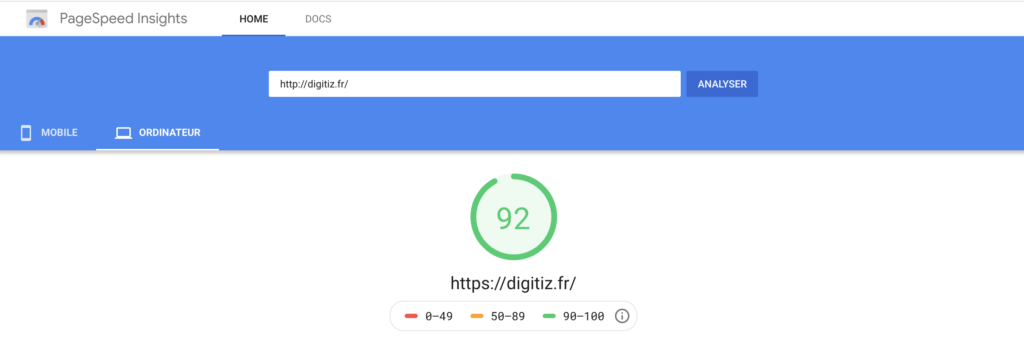

La vitesse du site

Plus votre site est rapide, notamment sur mobile, plus Google est susceptible de vous récompenser en vous favorisant dans ses résultats. À l’inverse, un temps de chargement relativement long peut vous pénaliser. C’est pourquoi il est important de toujours améliorer la vitesse de votre site internet.

PageSpeed Insights est un des outils que j’utilise pour analyser les versions mobile et bureautique de votre site. Il vous donne un aperçu de la vitesse de vos pages et vous propose des suggestions d’amélioration.

Les suggestions d’amélioration de la vitesse de chargement de votre site vont de l’élimination d’élément JavaScript et CSS à la simple compression d’images.

Étape 5 : Examiner les backlinks

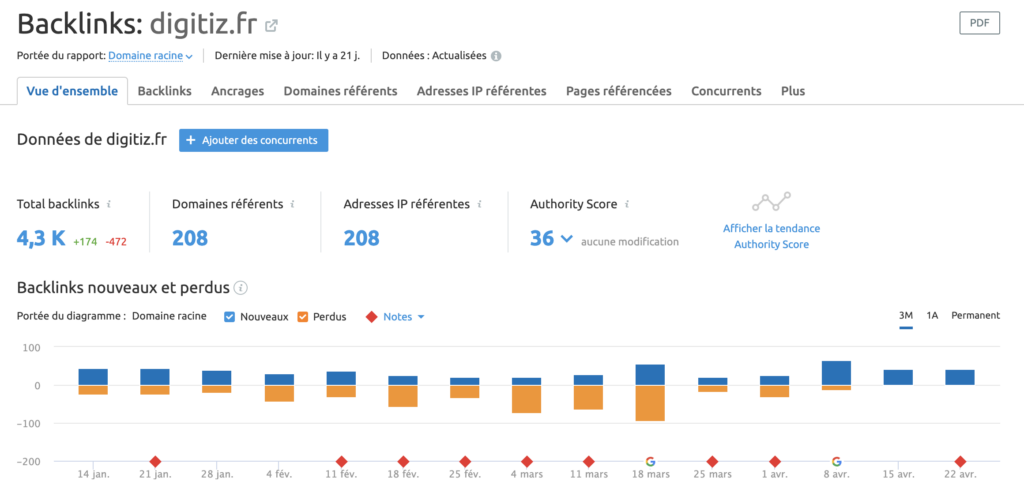

Les backlinks ou liens entrants ont toujours un rôle prépondérant dans les facteurs de positionnement de vos pages. Voici donc les points à vérifier pour analyser vos backlinks.

Le profil de liens

La première chose à faire est de vérifier votre profil de backlink. Vous pouvez inspecter vos backlinks à l’aide du rapport sur les liens entrants de la Google Search Console. Cependant, si vous voulez une analyse plus approfondie, je vous suggère d’utiliser SEMrush ou Majestic SEO.

L’objectif est d’évaluer votre profil de backlink et votre autorité de domaine de manière globale. Cela vous aidera à estimer si vous devez faire plus d’efforts pour créer des liens.

Sur SEMrush, vous pouvez aller dans Tableau de bord > Analyse de domaine > Backlinks et voir ainsi le détail de votre profil de liens.

Les principales informations que l’on retrouve dans les différents onglets sont :

- Le nombre total de backlinks

- Les ancres

- Le nombre de domaines référents

- Les pages référencées

Selon l’outil d’analyse que vous utilisez vous pouvez aussi avoir une notation de votre domaine. Pour SEMrush, on retrouve ainsi l’Authority Score ou bien le Trust Flow et le Citation Flow sur Majectic SEO.

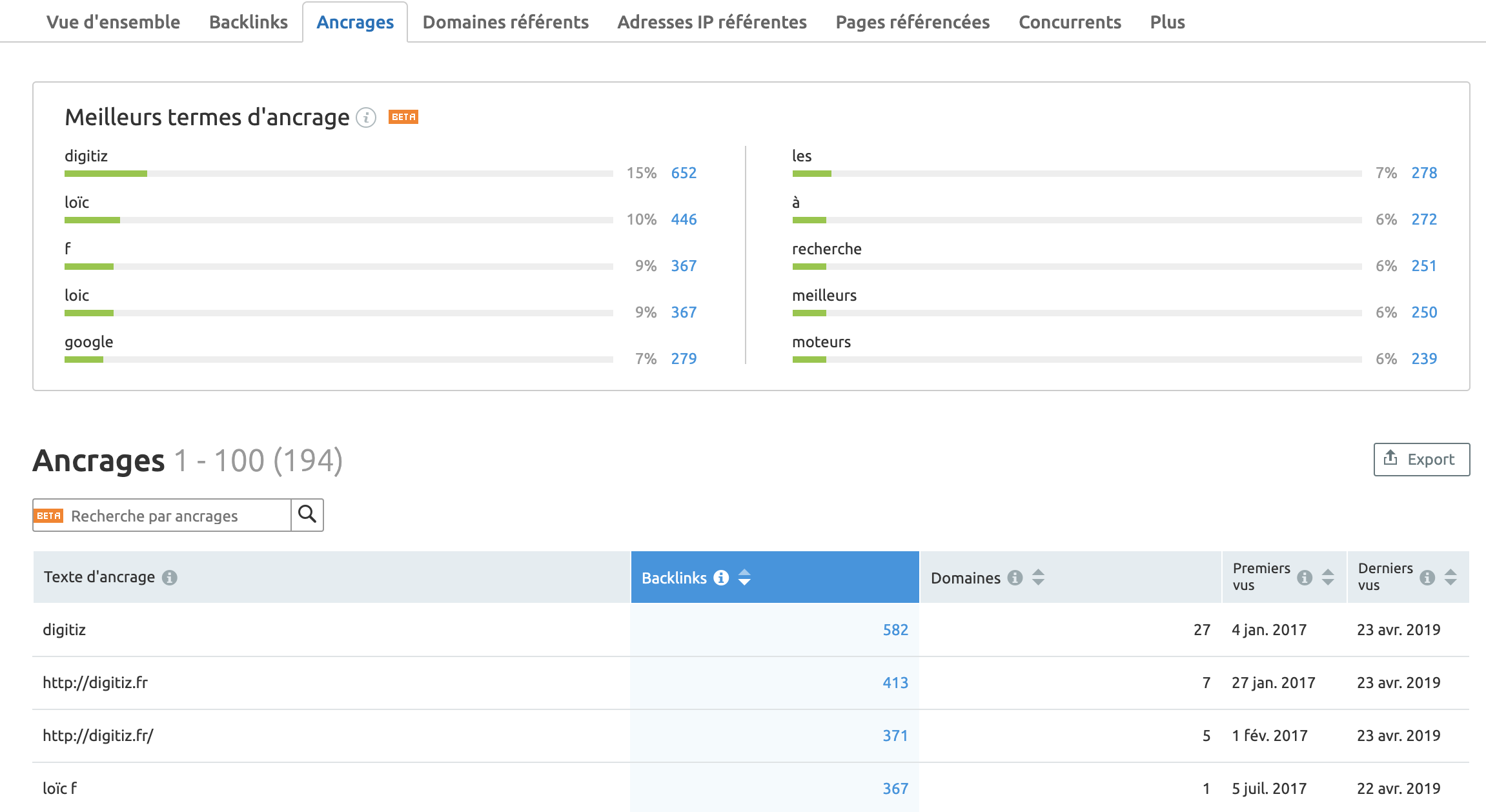

Les ancres de liens

Un aspect important en ce qui concerne les liens est la distribution des textes d’ancre. En général, la majeure partie des backlinks sont liés à des ancres de marque ou génériques. Les ancres peuvent aussi contenir les mots-clés que vous ciblez mais méfiez-vous à ce qu’elles ne soient pas non plus sur-optimisées ce qui pourrait entraîner un impact négatif en cas d’abus.

Dans SEMrush, l’onglet « Ancrage » permet de voir les termes les plus utilisés dans les ancres de liens et de vérifier qu’elles sont suffisamment diversifiées :

Les domaines référents

Passons à l’onglet « Domaines référents » dans le rapport SEMrush. Cette fois, on peut voir le nombre de backlinks par pays et inspecter chaque domaine de manière individuelle avec leurs scores d’autorité. Cela permet de comprendre la qualité des liens.

D’un point de vue SEO, il est conseillé d’avoir un portefeuille diversifié de domaines référent et en rapport avec notre thématique. Les moteurs de recherche considèrent cela comme plus naturel et vous donneront plus de crédit.

Vérifier que vos backlinks soient pertinents et de qualité et soyez à l’affût des backlinks suspects tels que les liens depuis les sites de spams qui sont considérés comme des liens de mauvaise qualité.

Pages liées

La dernière étape de l’audit de backlink consiste à regarder quelles sont les pages qui bénéficient le plus de backlinks afin d’améliorer la distribution du PageRank via le maillage interne

Il faut alors identifier les principales pages de destination à l’aide de l’onglet « Pages référencées » de SEMrush et « Liens externes » sur Search Console. Avec ces informations, vous pourrez mettre en place des liens internes entre vos pages qui bénéficient de liens et celles qui n’en ont pas encore mais que vous souhaitez pousser davantage dans les résultats Google.

Pour conclure

Il faut garder en tête que l’objectif de l’audit SEO est d’identifier les principales erreurs de votre site à un instant T. Une fois les problèmes corrigés, il ne faut pas considérer l’optimisation SEO comme définitivement terminé. Le référencement naturel est un travail continu et des améliorations doivent être apportées de manière régulière sur votre site web. L’étape suivante sera de remettre à plat votre stratégie SEO en ciblant les bons mots-clés avec une architecture de site efficace et un netlinking béton.

J’espère qu’avec cet article, vous avez pu avoir le maximum d’informations pour réaliser un audit SEO complet de votre site.

Vous pouvez bien sûr effectuer votre propre analyse SEO. Toutefois, en tant que consultant en référencement naturel, l’audit est un sujet sur lequel je peux évidemment vous aider.

N’hésitez pas à partager cet article si vous l’avez trouvé utile ou bien à me faire part de vos remarques et questions en commentaire.

Merci beaucoup pour cet article très complet sur le sujet !